Inteligența Artificială (IA) a stârnit imaginația omenirii de zeci de ani, promițând o lume mai bună, mai eficientă și mai confortabilă. Totuși, o voce disonantă se ridică din corul optimist: Ben Eisenpress, expert în IA, ne avertizează despre 5 moduri în care inteligenţa artificială ar putea distruge lumea.

De la Terminatorul la Matrix, roboții ucigași au fost mult timp o piesă de bază terifiantă a filmelor științifico-fantastice. Dar, deși în cinematografie sunt demni de speriat, ar trebui să ne temem cu adevărat de o inteligență artificială puternică și diabolică?

Plecând de la molime supraîncărcate şi până la anihilarea nucleară în toată regula, experții spun că există cinci moduri prin care inteligenţa artificială ar putea distruge lumea.

Ben Eisenpress, director de operațiuni la Future of Life Institute, a avertizat că „toate riscurile catastrofale ale IA sunt subestimate în prezent”.

Așadar, dacă încă mai credeți că apocalipsa IA nu este altceva decât un scenariu de film învechit, citiți mai departe pentru a vedea cât de îngrijorat ar trebui să fiți cu adevărat. Experții spun că scenariile științifico-fantastice precum cel din filmul Terminatorul, care duc la distrugerea umanității, trebuie luate în serios.[sursa]

5 scenarii prin care inteligenţa artificială ar putea distruge lumea

Ben Eisenpress a identificat cinci moduri neașteptate prin care inteligenţa artificială ar putea distruge lumea, dacă nu este reglementată și controlată corespunzător. Iată care sunt acestea:

#1. Inteligența artificială malefică

Când vă gândiți la IA care duce la distrugerea umanității, cel mai probabil, roboții ucigași sunt ceea ce aveți în minte.

O îngrijorare este că vom crea o IA atât de puternică încât omenirea să piardă capacitatea de a o controla, ceea ce duce la consecințe neintenționate.

Până de curând, acest lucru nu era nimic mai mult decât un scenariu pentru filme și un exercițiu teoretic pentru tehnologi. Dar acum, odată cu progresele rapide pe care le vedem în domeniul inteligenței artificiale, Ben Eisenpress spune că acest scenariu nu mai pare atât de îndepărtat.

„Inteligența artificială necinstită, în cazul în care inteligența artificială scapă de sub controlul uman și provoacă daune pe scară largă, reprezintă un risc real. Trebuie să vedem încotro se îndreaptă AI, nu doar unde se află astăzi. În ultimii ani s-au făcut progrese uimitoare. Experții prevăd că vor urma și mai multe.”, a declarat Ben Eisenpress.

#2. Arme biologice

Deocamdată, inteligența artificială în sine ar putea să nu reprezinte cel mai mare pericol – problema cea mai mare este reprezentată de ceea ce pot crea oamenii cu ajutorul inteligenței artificiale.

„Pe termen scurt, bioterorismul bazat pe inteligența artificială este probabil una dintre cele mai grave amenințări generate de dezvoltarea necontrolată a inteligenței artificiale.”, mai spune Eisenpress.

Și nu este singurul care își exprimă îngrijorarea. Recent, prim-ministrul britanic Rishi Sunak a folosit summitul privind siguranța IA din Bletchley Park pentru a trage un semnal de alarmă cu privire la armele biologice asistate de IA.

Un document de discuție al guvernului privind ‘AI de frontieră’, un termen pentru cea mai avansată inteligență artificială, a avertizat că ‘AI va continua aproape sigur să reducă barierele de intrare pentru actorii de amenințare mai puțin sofisticați’.

De asemenea, Dario Amodei, fondatorul firmei de inteligență artificială Anthropic, a avertizat Congresul SUA că AI ar putea ajuta infractorii să creeze arme biologice în termen de doi-trei ani.

Cercetătorii au descoperit că un instrument conceput pentru descoperirea de medicamente benefice ar putea fi ușor convertit pentru a descoperi noi toxine biochimice.

În mai puțin de șase ore, AI a prezis peste 40.000 de noi molecule toxice – multe dintre ele mai periculoase decât armele chimice existente.

Ben Eisenpress spune că îngrijorarea sa este că „actorii răi”, cum ar fi grupurile teroriste, vor putea să transforme aceste instrumente pentru a dezlănțui molime devastatoare sau atacuri chimice.

#3. IA lăsată în libertate în mod deliberat

Pentru a înțelege de ce ar putea fi devastator să lași un program de calculator prost înțeles să se dezlănțuie, nu este nevoie să speculezi asupra viitorului.

În anul 2017, sisteme informatice fără legătură între ele din întreaga lume au început brusc să aibă probleme inexplicabile. Cel mai mare port de containere din India a fost blocat, sistemul de monitorizare a radiațiilor de la centrala nucleară de la Cernobîl a fost deconectat, iar băncile, firmele farmaceutice și spitalele au pierdut brusc controlul asupra sistemelor lor.

Vinovatul a fost virusul NotPetya, o armă cibernetică foarte probabil creată de armata rusă pentru a ataca Ucraina.

Dar când virusul s-a scurs, s-a răspândit mult mai mult decât se așteptau creatorii săi, ducând la pagube estimate la 10 miliarde de dolari (7,93 miliarde de lire sterline).

La fel ca și în cazul armelor biologice, IA stă să supraîncarce capacitatea armelor cibernetice până la noi niveluri de distrugere. Îngrijorător este faptul că acest proces ar putea să fi început deja.

Departamentul de Stat al SUA a avertizat: „Am observat că unii actori nord-coreeni și alți actori naționali și criminali încearcă să folosească modele de inteligență artificială pentru a ajuta la accelerarea scrierii de software malițios și la găsirea de sisteme pe care să le exploateze”.

Există, de asemenea, temeri că actorii răi ar putea dezlănțui în mod deliberat o IA necinstită în lume.

În anul 2023, cercetătorii de la Centre for AI Safety au scris: „Eliberarea unor AI puternice și permiterea acestora să întreprindă acțiuni independent de oameni ar putea duce la o catastrofă”.

Cercetătorii au subliniat că, la numai o lună de la lansarea GPT-4, un proiect open-source a ocolit deja filtrele de siguranță pentru a crea un agent instruit să „distrugă umanitatea”, să „stabilească o dominație globală” și să „atingă nemurirea”.

„Denumit ChaosGPT, AI-ul a compilat cercetări privind armele nucleare și a trimis tweet-uri încercând să îi influențeze pe alții.”, au precizat cercetătorii.

Din fericire, acest agent nu a avut capacitatea de a sparge computere, de a supraviețui sau de a se răspândi, dar a venit ca un avertisment important privind riscurile pe care le prezintă inteligența artificială rău intenționată.

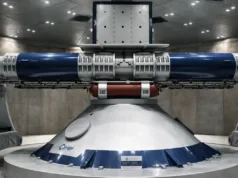

#4. Războiul nuclear

Procesul de luare a deciziilor militare privind armele nucleare ar putea fi încredințat IA. În acest caz, conflictul ar putea escalada rapid într-un „război fulger” care ar putea distruge lumea.

Războiul modern se bazează pe colectarea și procesarea unor cantități uriașe de informații. Câmpurile de luptă devin rețele enorme de senzori și factori de decizie, iar un atac devastator poate sosi mai repede ca niciodată.

Din acest motiv, armatele lumii încep acum să ia în considerare implementarea inteligenței artificiale în sistemele lor de luare a deciziilor.

Strategia de inteligență artificială în domeniul apărării din anul 2022 a Ministerului Apărării al Marii Britanii a avertizat că acest lucru ar putea „să pună la încercare limitele înțelegerii umane și să necesite adesea răspunsuri la viteza mașinii”.

Dar Ben Eisenpress spune că încorporarea IA în sistemele militare poate duce la pericole și mai mari, în special în cazul armelor nucleare.

La fel ca în clasicul WarGames din anul 1983, utilizarea IA pentru a controla armele nucleare ar putea duce la un război nuclear.

„Sistemele de inteligență artificială de astăzi sunt în mod inerent nesigure, capabile să ia decizii inexplicabile și să «halucineze». Integrarea IA în sistemele de comandă și control nuclear este destabilizatoare.”, a mai Spus Ben Eisenpress.

Una dintre îngrijorări este că luarea rapidă a deciziilor de către AI ar putea duce la mici erori, de exemplu, identificarea greșită a unui avion, care ar putea escalada rapid într-un război în toată regula.

Odată ce AI a făcut eroarea inițială, AI-urile diferitelor națiuni ar putea reacționa între ele mai repede decât ar putea controla orice om, ducând la un „război fulger”.

„Chiar dacă, din punct de vedere tehnic, există un «om în buclă», nu ne putem baza pe factorii de decizie pentru a trece peste o recomandare de lansare potențial eronată generată de AI, având în vedere astfel de mize existențiale.”, conchide Ben Eisenpress.

#5. Înlocuirea treptată

Gândul unui război termonuclear indus de inteligența artificială este terifiant. Dar dacă omenirea nu se termină cu un bang, ci cu un scâncet?

Ben Eisnepress spune că un mod în care ne-am putea împiedica de sfârșitul umanității așa cum o știm este printr-o preluare lentă și silențioasă.

„Modul nostru «Gradual AI Disempowerment» spune povestea modului în care oamenii ar putea ceda treptat controlul asupra lumii noastre către IA, fără un singur moment dramatic.”, a spus Eisenpress.

De la tranzacții financiare la proceduri juridice, multe sarcini au fost deja predate AI-ului.

„În timp, IA va fi integrată în tot mai multe sisteme, inclusiv în cele esențiale pentru modul nostru de viață. Companiile sau partidele politice care refuză să valorifice IA vor pierde în fața celor care o fac, creând o cursă spre bază. Încetul cu încetul, oamenii vor avea mai puțin control asupra lumii. Ne-am putea trezi la mila AI, fără ca măcar să ne dăm seama ce se întâmplă.”, a mai precizat Ben Eisenpress.

Pentru a înțelege riscul cu care ne confruntăm, Eisenpress spune să privim nu spre viitor, ci spre trecut.

„Ne-am putea trezi la mila AI, fără ca măcar să ne dăm seama ce se întâmplă. Neputinţa este rezultatul implicit atunci când apare o entitate mai inteligentă și mai capabilă. întrebați-i doar pe neanderthalieni. Ei au prosperat timp de sute de mii de ani, doar pentru a dispărea rapid atunci când oamenii moderni au intrat în scenă.”, a mai spus Eisenpress.

Ben Eisenpress încheie cu un citat din Alan Turing, fondatorul informaticii moderne, care a scris în anul 1915: „Nu va dura mult timp până când vor depăși puterile noastre slabe… La un moment dat, trebuie să ne așteptăm ca mașinile să preia controlul”.

Scenariile descrise de Ben Eisenpress nu sunt SF ieftin, ci o avertizare bazată pe realitatea actuală a dezvoltării inteligenţei artificiale. Ignorarea pericolelor ar putea fi o greșeală fatală.